上回讲到数学上如何定义不确定性问题,只要上过高中的同学听到不确定性都会想到概率论。那么什么是概率呢?一般通俗的说,概率就是一个事件的可能性。书本中的定义事件的概率是衡量该事件发生的可能性的量度。关于概率的定义问题,科学家们一起讨论了3个世纪,苏联数学家柯尔莫哥洛夫1933年在他的《概率论基础》一书中第一次给出了概率的测度论的定义和一套严密的公理体系。他的公理化方法成为现代概率论的基础,使概率论成为严谨的数学分支。 所以我们看似显而易见的东西每前进一小步都是非常困难的。

以下是公理化定义:

设随机实验E的样本空间为Ω。若按照某种方法,对E的每一事件A赋于一个实数P(A),且满足以下公理:

1°非负性:P(A)≥0;

2°规范性:P(Ω)=1;

3°可列(完全)可加性:对于两两互不相容的可列无穷多个事件A1,A2,……,An,……,有P(A1∪A2∪……∪An∪……)=P(A1)+P(A2)+……P(An)+……,则称实数P(A)为事件A的概率。为什么要3个世纪呢?在数学中公理不是推断出来的,是臆想出来的,如何让臆想出来的东东让广大人民群众认可是因为通过这个公理推断出的定理可以解释一部分世界运行的规则。

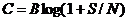

1948年香农在概率论的基础上发表了“A Mathematical Theory of Communication”(《通信的数学原理》),标志了信息论得诞生。他在论文当中定义了信息的度量单位比特、信息熵和信道容量,并证明了AWGN信道的信道容量为C=Blog(1+S/N),指引了信息产业的发展。香农是美国科学院和工程院院士,一生获奖无数,以他的名字命名的“香农奖”,是信息论领域的最高奖。

首先香农定义信息的度量单位是bit,就是8位机,16位机,32位机,64位机的位。大家应该都明白哈。信息论是关于信息的理论,我们看看香农给出的信息的定义。

一个随机事件发生的概率为p,那么它的自信息为

I = -log(p)

概率p肯定是一个小于1的数,取对数是负数,前面再加一个负号就成了正数,也可以以不同的数为底,如果以2为底,信息的单位就是bit。

首先,信息是和概率直接相关的。你可以看到,一个事件的信息由其概率唯一决定。

那么什么是概率呢?比如有一个袋子,里面有两个求,一个是红色的,一个是白色的。我们随机摸一个球出来,让你来说是什么颜色,然后放回去,继续摸。如果只告诉你前提(有两个球,一个红色,一个白色),而不告诉你摸出来的球的任何信息,随便你猜,怎么猜都可以,例如全是红的,或者全是白的,或者一半一半,无论你怎么猜,你能够才对的概率是50%,不会对得更多,也不会对得更少。

什么是信息呢?以这个红白球的例子来说,有些东西是确定的,比如一共有两个球,一个红色的,一个白色的,摸球的方法是随机的而不是有所偏好。这些确定的东西,是我们已经知道的,不需要去猜,加作先验信息。但是每一次摸出来的球的颜色,单靠猜,我们只能猜对一半。也就是说,这个事件对我们来说具有不确定度。我们要想完全说对球的颜色,也就是消除这种不确定度,所需要的那个东西就是信息。我们改变一种说法,还是红白球的游戏,只不过条件变成袋子里面有1024个球;其中有1023个红球,有1个白球,会发生什么情况呢?

很明显,摸出来的红球概率比较大,为1023/1024,而摸出来的白球的概率为1/1024。现在再让你猜球的颜色,你肯定说红球,因为猜对的概率是1023/1024;但是你还会担心1/1024白球出现的概率,仍有不确定性。如果我们可以标注白球的位置,1024是2的10次方,也就是用10个bit就可以表示白球出现的位置,那么你能完全知道摸的是白球还是红球。也就是说在这个例子中用一个10bit的数就可以让不确定的事变成确定的事。那么如何定义一个事件的信息的多寡呢?从前面对红白球的讨论看,信息是由概率决定的,是概率的函数。而且,概率越大,信息就越少;概率越小,信息就越大。香农研究后发现,采用对概率取对数再取负号的方法比较合适。白球的概率为1/1024,白球的自信息是I = -log(1/1024)=10 (bit)。同学们花这么多精力讲概念的问题让大家明白“信息”就是为了减少不确定性而所需要的大小。概率是用来发现问题,评估问题;信息用来解决问题。如果到此看懂了,恭喜你已经达到在读研究生水平了;我们继续奋往向前。

刚才我们描述的是白球这个事件的信息,只是一个局部的描述,我们还需要对一个信源进行整体的描述。信源就是信息的源泉。信源可以分为连续的和离散的,有记忆的和无记忆的。连续指的是时间连续,离散指的是时间离散。无记忆信源,是指当前事件的发生概率,与上一个事件没有关系;如果有关系就是记忆信源。问题来了,把这篇文章当成一个信源是什么类型?隔(tou)离(kan)一(da)下(an),每个汉子都是有一定发生概率,是一个离散信源;同时也是记忆信源,你看到了“记”,下个字是“忆”的概率就很大了。如果你家的狗狗看这篇文章,请教是什么类型信源啊?剧透一下,中国人看了这篇文章信息论就用在自然语言处理领域;狗狗看了这篇文章信息论就用在图像处理领域。都是属于通信的大范畴。

离散无记忆信源是最简单的信源,可以用一个集合来表示,集合当中的每个元素就是事件,每个事件都有一个发生的概率。可以表达为一个概率分布的集合{

}。

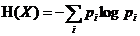

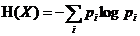

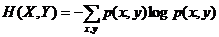

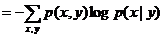

对于这样一个信源,用来描述其信息论属性的概念,就是厉害了word信息熵,简称为熵(entropy),香农这样来表示他:

不要晕,

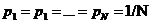

就是每个事件的自信息,乘以概率求和就是平均的意思。所以熵就是信源当中所有事件的自信息的平均值,它反映了一个信源整体的不确定度。数学上可以证明当集合中的每个事件等概率分布(

)的时候达到最大值。谁证明出来送积分哈!这个数学结构一点也不逆人性啊,红白球的例子中,两种颜色概率相等的时候最难猜。语言文字也是非等概率分布的,常用字使用频率可以是生僻字的上百倍,这样的特性降低了自然语言处理不确定性。

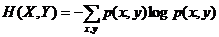

天时,地利,人合,事出多因。信息论也发展出了联合熵和条件熵。

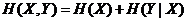

联合熵的定义:

天时,地利两个因素同时考虑即计算p(x,y)联合概率即可,意思是同时满足天时地利两个因素的概率。

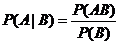

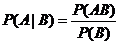

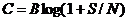

对于条件熵,先看看条件概率公式:

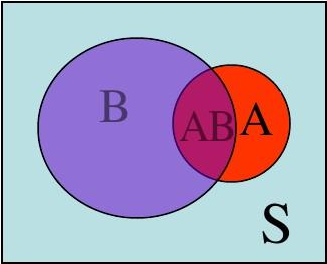

大家看图说话:

P(A|B)是在B作为样本空间S的前提下(即B一定发生的情况下),P(AB)的相对概率。

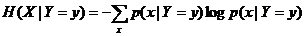

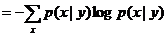

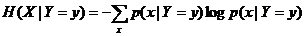

条件熵描述的是以某个事件为条件时,X的不确定度。如果这个事件是一个具体的事件,比如随机变量Y=y,则X的不确定度为

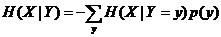

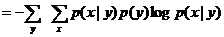

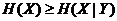

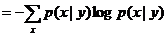

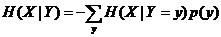

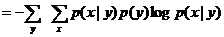

因为Y是一个随机变量,对H(X|Y=y)取统计平均,得到的是在Y发生的总体条件下的X的不确定度,也就是条件熵的定义

大家可以看懂吗?注意

下标啊。里面用了条件概率的变换公式。

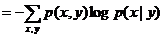

联合熵和条件熵满足链式法则(Chain Rule)

回复中证明的,奖积分!

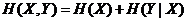

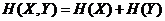

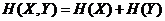

在X,Y相互独立的情况下:

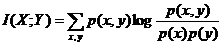

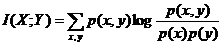

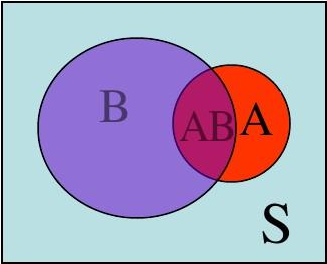

大家快吐了吧,看到公式就头大,再忍一忍,再来一发,香农还提出互信息的概念,对于离散随机变量X,Y,其互信息定义为

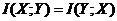

因为形式对称,也容易看出:

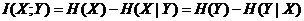

可以证明:

回复中证明的,奖积分!

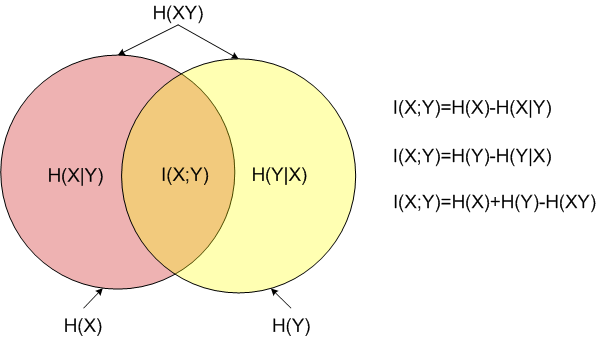

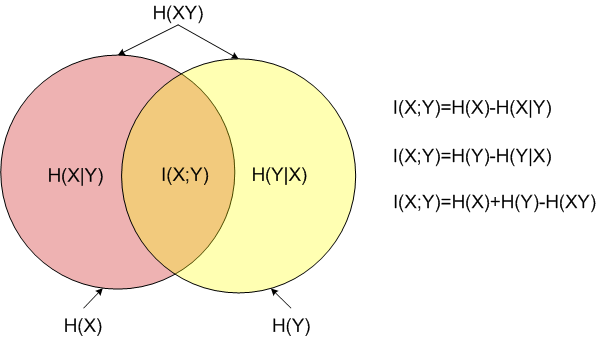

搞了这么多公式,我们来画个图:

数学家发现了公式还是要用的嘛!来看看这些定义是怎么再现实世界中发挥作用的。

对于条件熵的解释由图可得

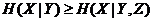

,说明多了Y的信息后,X的不确定下降了!之前说到的“记忆”,如果Y是“记”出现的不确定性,那么在“记”出现之后,X(即“忆”)出现的不确定性要大大降低!在数学上就证明了二元模型的不确定性小于一元模型。可以这么理解当我们听到记这个字时,对后一个忆字的发音只要了解大概我们也可以猜出来(还是有不确定性的,可以降低不确定性)。在通信中可以大大降低带宽,在图像识别中可以大大压缩存储空间。道理都是一样的。当然,三元模型比二元模型更好,有兴趣的同学可以证明

。

对于互信息直观的例子是“苹果很贵!”。有两种理解一是苹果(水果)很贵,另一种是iphone很贵。机器如何识别呢?这时候就用互信息。首先从大量的文本中找出和水果苹果出现的互信息最大的一些词,比如水果,水果摊,水分,甜,新鲜等等,当然再用同样的方法找出和苹果(iphone)同时出现的互信息最大的词,比如ios,手机,5,6,7,外壳,土豪金等等。互信息本质就是了解了其中一个Y(水果)的前提下,对消除另一个X(苹果)不确定性所提供的信息量。香农把互信息作为两个随机事件“相关性”的量化度量

大家累了吧,下节我们继续吹捧香农,让他最伟大的公式

浮出水面。

上回讲到数学上如何定义不确定性问题,只要上过高中的同学听到不确定性都会想到概率论。那么什么是概率呢?一般通俗的说,概率就是一个事件的可能性。书本中的定义事件的概率是衡量该事件发生的可能性的量度。关于概率的定义问题,科学家们一起讨论了3个世纪,苏联数学家柯尔莫哥洛夫1933年在他的《概率论基础》一书中第一次给出了概率的测度论的定义和一套严密的公理体系。他的公理化方法成为现代概率论的基础,使概率论成为严谨的数学分支。 所以我们看似显而易见的东西每前进一小步都是非常困难的。

以下是公理化定义:

设随机实验E的样本空间为Ω。若按照某种方法,对E的每一事件A赋于一个实数P(A),且满足以下公理:

1°非负性:P(A)≥0;

2°规范性:P(Ω)=1;

3°可列(完全)可加性:对于两两互不相容的可列无穷多个事件A1,A2,……,An,……,有P(A1∪A2∪……∪An∪……)=P(A1)+P(A2)+……P(An)+……,则称实数P(A)为事件A的概率。为什么要3个世纪呢?在数学中公理不是推断出来的,是臆想出来的,如何让臆想出来的东东让广大人民群众认可是因为通过这个公理推断出的定理可以解释一部分世界运行的规则。

1948年香农在概率论的基础上发表了“A Mathematical Theory of Communication”(《通信的数学原理》),标志了信息论得诞生。他在论文当中定义了信息的度量单位比特、信息熵和信道容量,并证明了AWGN信道的信道容量为C=Blog(1+S/N),指引了信息产业的发展。香农是美国科学院和工程院院士,一生获奖无数,以他的名字命名的“香农奖”,是信息论领域的最高奖。

首先香农定义信息的度量单位是bit,就是8位机,16位机,32位机,64位机的位。大家应该都明白哈。信息论是关于信息的理论,我们看看香农给出的信息的定义。

一个随机事件发生的概率为p,那么它的自信息为

I = -log(p)

概率p肯定是一个小于1的数,取对数是负数,前面再加一个负号就成了正数,也可以以不同的数为底,如果以2为底,信息的单位就是bit。

首先,信息是和概率直接相关的。你可以看到,一个事件的信息由其概率唯一决定。

那么什么是概率呢?比如有一个袋子,里面有两个求,一个是红色的,一个是白色的。我们随机摸一个球出来,让你来说是什么颜色,然后放回去,继续摸。如果只告诉你前提(有两个球,一个红色,一个白色),而不告诉你摸出来的球的任何信息,随便你猜,怎么猜都可以,例如全是红的,或者全是白的,或者一半一半,无论你怎么猜,你能够才对的概率是50%,不会对得更多,也不会对得更少。

什么是信息呢?以这个红白球的例子来说,有些东西是确定的,比如一共有两个球,一个红色的,一个白色的,摸球的方法是随机的而不是有所偏好。这些确定的东西,是我们已经知道的,不需要去猜,加作先验信息。但是每一次摸出来的球的颜色,单靠猜,我们只能猜对一半。也就是说,这个事件对我们来说具有不确定度。我们要想完全说对球的颜色,也就是消除这种不确定度,所需要的那个东西就是信息。我们改变一种说法,还是红白球的游戏,只不过条件变成袋子里面有1024个球;其中有1023个红球,有1个白球,会发生什么情况呢?

很明显,摸出来的红球概率比较大,为1023/1024,而摸出来的白球的概率为1/1024。现在再让你猜球的颜色,你肯定说红球,因为猜对的概率是1023/1024;但是你还会担心1/1024白球出现的概率,仍有不确定性。如果我们可以标注白球的位置,1024是2的10次方,也就是用10个bit就可以表示白球出现的位置,那么你能完全知道摸的是白球还是红球。也就是说在这个例子中用一个10bit的数就可以让不确定的事变成确定的事。那么如何定义一个事件的信息的多寡呢?从前面对红白球的讨论看,信息是由概率决定的,是概率的函数。而且,概率越大,信息就越少;概率越小,信息就越大。香农研究后发现,采用对概率取对数再取负号的方法比较合适。白球的概率为1/1024,白球的自信息是I = -log(1/1024)=10 (bit)。同学们花这么多精力讲概念的问题让大家明白“信息”就是为了减少不确定性而所需要的大小。概率是用来发现问题,评估问题;信息用来解决问题。如果到此看懂了,恭喜你已经达到在读研究生水平了;我们继续奋往向前。

刚才我们描述的是白球这个事件的信息,只是一个局部的描述,我们还需要对一个信源进行整体的描述。信源就是信息的源泉。信源可以分为连续的和离散的,有记忆的和无记忆的。连续指的是时间连续,离散指的是时间离散。无记忆信源,是指当前事件的发生概率,与上一个事件没有关系;如果有关系就是记忆信源。问题来了,把这篇文章当成一个信源是什么类型?隔(tou)离(kan)一(da)下(an),每个汉子都是有一定发生概率,是一个离散信源;同时也是记忆信源,你看到了“记”,下个字是“忆”的概率就很大了。如果你家的狗狗看这篇文章,请教是什么类型信源啊?剧透一下,中国人看了这篇文章信息论就用在自然语言处理领域;狗狗看了这篇文章信息论就用在图像处理领域。都是属于通信的大范畴。

离散无记忆信源是最简单的信源,可以用一个集合来表示,集合当中的每个元素就是事件,每个事件都有一个发生的概率。可以表达为一个概率分布的集合{

}。

对于这样一个信源,用来描述其信息论属性的概念,就是厉害了word信息熵,简称为熵(entropy),香农这样来表示他:

不要晕,

就是每个事件的自信息,乘以概率求和就是平均的意思。所以熵就是信源当中所有事件的自信息的平均值,它反映了一个信源整体的不确定度。数学上可以证明当集合中的每个事件等概率分布(

)的时候达到最大值。谁证明出来送积分哈!这个数学结构一点也不逆人性啊,红白球的例子中,两种颜色概率相等的时候最难猜。语言文字也是非等概率分布的,常用字使用频率可以是生僻字的上百倍,这样的特性降低了自然语言处理不确定性。

天时,地利,人合,事出多因。信息论也发展出了联合熵和条件熵。

联合熵的定义:

天时,地利两个因素同时考虑即计算p(x,y)联合概率即可,意思是同时满足天时地利两个因素的概率。

对于条件熵,先看看条件概率公式:

大家看图说话:

P(A|B)是在B作为样本空间S的前提下(即B一定发生的情况下),P(AB)的相对概率。

条件熵描述的是以某个事件为条件时,X的不确定度。如果这个事件是一个具体的事件,比如随机变量Y=y,则X的不确定度为

因为Y是一个随机变量,对H(X|Y=y)取统计平均,得到的是在Y发生的总体条件下的X的不确定度,也就是条件熵的定义

大家可以看懂吗?注意

下标啊。里面用了条件概率的变换公式。

联合熵和条件熵满足链式法则(Chain Rule)

回复中证明的,奖积分!

在X,Y相互独立的情况下:

大家快吐了吧,看到公式就头大,再忍一忍,再来一发,香农还提出互信息的概念,对于离散随机变量X,Y,其互信息定义为

因为形式对称,也容易看出:

可以证明:

回复中证明的,奖积分!

搞了这么多公式,我们来画个图:

数学家发现了公式还是要用的嘛!来看看这些定义是怎么再现实世界中发挥作用的。

对于条件熵的解释由图可得

,说明多了Y的信息后,X的不确定下降了!之前说到的“记忆”,如果Y是“记”出现的不确定性,那么在“记”出现之后,X(即“忆”)出现的不确定性要大大降低!在数学上就证明了二元模型的不确定性小于一元模型。可以这么理解当我们听到记这个字时,对后一个忆字的发音只要了解大概我们也可以猜出来(还是有不确定性的,可以降低不确定性)。在通信中可以大大降低带宽,在图像识别中可以大大压缩存储空间。道理都是一样的。当然,三元模型比二元模型更好,有兴趣的同学可以证明

。

对于互信息直观的例子是“苹果很贵!”。有两种理解一是苹果(水果)很贵,另一种是iphone很贵。机器如何识别呢?这时候就用互信息。首先从大量的文本中找出和水果苹果出现的互信息最大的一些词,比如水果,水果摊,水分,甜,新鲜等等,当然再用同样的方法找出和苹果(iphone)同时出现的互信息最大的词,比如ios,手机,5,6,7,外壳,土豪金等等。互信息本质就是了解了其中一个Y(水果)的前提下,对消除另一个X(苹果)不确定性所提供的信息量。香农把互信息作为两个随机事件“相关性”的量化度量

大家累了吧,下节我们继续吹捧香农,让他最伟大的公式

浮出水面。

举报

举报

举报

举报