引言

本文采用ARM+DSP双核架构的OMAP3530系列的处理器,道路图像处理部分由支持浮点运算的DSP核来完成,图像采集工作和系统的控制工作由ARM核来完成,这样的作业分配提高了系统的实时性、集成性和可靠性。

车道线识别算法研究

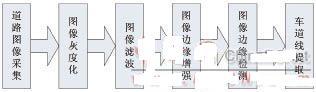

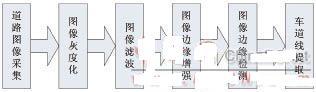

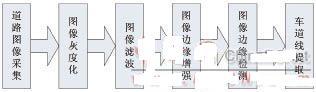

本文提出的车道线识别算法的流程如下图1所示,首先通过OV7670摄像头捕获道路图像,然后按照流程图中的步骤处理图像,最后得到清晰的车道标志线,为以后智能车辆路径规划和避障提供支持。

道路图像灰度化

图像灰度变换是对图像像素进行拉伸,从而扩大图像的灰度级范围,进一步扩展图像的对比度、增加图像的动态范围、使图像更加清晰、特征更加明显,是图像增强的有效手段。我们采集到的道路图像是彩色图像,颜色模型采用RGB模型。由于人眼对颜色的敏感度不同,等量的红、蓝、绿混合不能得到对应亮度相同的灰度值,大量的实验数据表明,当使用0.3份红色、0.59份绿色、0.11份蓝色混合后可以得到最合理的灰度图像,即如公式(1)所示:

灰度值=0.3R+0.59G+0.11B(1)

根据公式(1)就可以算出当前像素对应的灰度值,将其作为图像中彩色像素对应的灰度值。

道路图像滤波

原始图像都或多或少的存在噪声干扰,噪声影响了后续图像的分析。这就要求在分析图像之前对图像进行滤波,去除噪声和假轮廓,图像滤波的过程就是让图像的低频成分通过,阻止属于高频部分中的噪声信号,也就是平时所说的低通滤波。但是在图像平滑过程中也阻止了高频部分的图像边缘,使得图像边缘模糊化。所以应找到能消除噪声,同时尽量保持图像细节,边缘轮廓的算法,又要保证智能车辆视觉导航系统对实时性的要求。中值滤波能够在抑制高频信号中的随机噪声的同时不使边缘模糊,可以抑制随机的点状噪声,抑制持续期小于1/2窗口的脉冲信号,但不影响斜坡信号和阶跃信号,能够削弱三角信号中的顶部峰值信号,因而受到欢迎,它属于非线性滤波。

中值滤波是将邻域中的像素按灰度级排序,取其中间值为输出像素。中值计算过程中使用到的像素数和邻域的空间范围影响到中值滤波的效果。本文采用3×3方形中值滤波模板对图像进行预处理既能取得较好的滤波效果,又能节省运算时间。

图像边缘增强

在车辆视觉导航系统中,道路边缘信息可以提供路径保持和路径跟踪的位置信息,是实现车辆自主导航功能不可或缺的。边缘增强的目的在于突出道路的边缘信息,以利于道路车道线的识别,有助于克服道路光照不均的影响。我们对滤波后的图像从水平和垂直两个方向进行边缘增强,可以得到非常好的效果。

图像边缘检测

在图像的多目标检测和识别技术中,边缘检测作为一种预处理算法在机器视觉技术中占有重要地位。边缘检测的算法很多,参考各种算法的优缺点,并结合道路检测的复杂性,我们这里选用Sobel算子。

Sobel边缘算子是一种一阶差分算子。它可以有效地消除道路图像中的大部分无用信息。它可以有效的抑制图像中的噪声,它的计算量比较小,容易实现,对于实时性要求比较高的系统,该算法有很大的优势。

车道标志线提取

本文重点讨论道路区域车道线的提取。日常生活中最常见的路面边界是直线,车辆主要也是在直线路面上行驶的。平时见到的直线路面边界是成一定角度的两条直线,根据三维空间点投影到二维平面的特点,直线路面边界在二维平面上形成两条相交的直线,直线路面边缘提取算法如下:

(1)根据二维直线路面的实际情况,建立X-Y坐标系,并给出恰当的路面边缘解析方程。

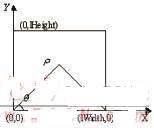

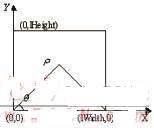

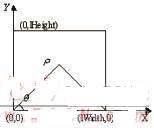

(2)根据图像的特点,取一组合理的ρ、θ范围和步长,设置累加器为零。将图像的解析方程转化成极坐标下的形式,即ρ=xcosθ+ysinθ,如图2所示,ρ为原点到直线垂直距离,θ为X轴与垂线之间的夹角。

(3)对梯度图上超过门限值的每个点作Hough变换,并对相应的累加器加1.

(4)找出累加器A(ρ,θ)上的极大值ρM、θM.通过这两个值可以找出图像中极有可能的边界。

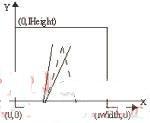

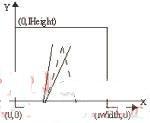

(5)去除干扰。根据三维物体在摄像机上成像的特点,三维空间中平行的路面边缘在二维平面形成两条成一定角度的相交直线,如图3中虚线所示。但由于路面噪声的影响,在累加器A(ρ,θ)上的极大值ρM、θM周围存在多个较大值,它们在X-Y轴上对应的直线如图3中两条实线所示,显然这不是要求的边缘,所以将累加器ρM、θM周围点置0.

(6)找出累加器A(ρ,θ)上次大值ρM、θM.A(ρ,θ)上的次大值对应图像中路面的另一条边界。

(7)得到相应的X-Y上对应直线方程。进一步可以得到:b=-ρ/sinθ,k=ctgθ通过这两个方程式得到ρ、θ值之后,可以求得相应的k、b值。

由于图像的连续性,图像序列中车道线的位置不会发生突变,我们在识别一帧图像的车道线时是以上一帧的识别结果为依据,动态地规划搜索区域,动态地规划Hough变化的ρ和θ值,这样就减少了计算量,提高了算法的实时性,也可提高可靠性。

系统硬件设计

本文选取ICETEK-OMAP3530-Mini开发板为实验平台,该开发板是由北京瑞泰创新科技有限责任公司与美国德州仪器公司合作推出,是一个开放的OMAP3530的硬件平台,它是以TI最新的、高性能的ARM CortexA8处理器OMAP3530为核心,以DSP64x+内核作为强劲的辅助图像处理,优化硬件2D/3D加速器,形成一个精简完备的计算机系统。

选用CMOS摄像头OV7670.OV7670是Omnivision公司生产的一款30万像素的彩色图像传感器芯片,体积小、工作电压低,提供单片VGA摄像头和影像处理器的所有功能。其特点有:灵敏度高,适合低亮度下使用;标准串行摄像头控制总线(SCCB),兼容IIC接口;自动曝光控制;自动增益控制;自动白平衡;自动消除灯光条纹;自动黑电平校准;图像格式可以是原始RGB、RGB(4:2:2)、RGB565/555/444、YUV(4:2:2)、YCbCr(4:2:2)。OV7670与ICETEK-OMAP3530-Mini板通过USB接口连接在一起。

系统软件设计

OMAP3530是一款双核微处理器,由ARM核和DSP核两部分组成,二者之间软件的编程和运行都是相互独立的,通过DSP/BIOS Link完成双核之间的通信。ARM端采用嵌入式Linux操作系统,动态创建、控制和删除DSP节点,实现数据的高效传输。DSP端采用DSP/BIOS实时操作系统,支持eXPressDSP实时软件技术,由DSP/BIOS实时内核、可重构的DSP算法和第三方软件模块组成。

由系统结构可见,软件设计主要包括:ARM端引导程序和Linux系统的移植;捕获道路图像程序。

ARM端引导程序和Linux系统的移植

为便于项目的开发和调试,ICETEK-OMAP3530-Mini板采用SD卡启动,本系统中使用的X-Loader的版本是x-loader1.4.2,U-boot的版本是Uboot-2009.01,Linux内核的版本是Linux-2.6.28,Busybox的版本是busybox-1.12.2,该过程的主要步骤如下:

(1)在开发主机Linux PC里安装交叉编译工具;

(2)交叉编译X-Loader,生成镜像文件x-load.bin.ift,然后转化为SD卡启动用程序MLO;

(3)交叉编译U-boot,生成u-boot.bin和mkimage工具;

(4)驱动配置并交叉编译内核,生成内核镜像文件uImage;

(5)利用Busybox制作文件系统;

(6)将上述生成的二进制文件复制到SD.

捕获道路图像

Linux系统对视频设备的操作提供了两套API,分别是Video 4 Linux(简称V4L)和Video 4 Linux 2(简称V4L2)。早期开发的V4L存在很多缺陷,Bill Dirks等人对其进行了重新设计,更名为V4L2,相比于V4L有很好的扩展性和灵活性,并且支持更多的硬件设备。这两套API不兼容,本文采用V4L2进行USB摄像头视频编程。

利用V4L2提供的接口,我们可以编写出具有视频采集功能的测试代码。下面就主要的环节做一些说明。

(1)打开视频设备

cameraFd=open(“/dev/video0”, O_RDWR, O);

(2)查询设备属性

通过调用ioctl函数和接口命令VIDIOC_QUERYCAP,查询摄像头的信息,见程序段1.

———————————————————————

if (ioctl(fd, VIDIOC_QUERYCAP, == -1) {

…

} else {…

if ((cap.capabilities V4L2_CAP_VIDEO_CAPTURE) == V4L2_CAP_VIDEO_ CAPTURE) {

…}

if ((cap.capabilities V4L2_CAP_STREAMING) == V4L2_CAP_STREAMING) {

…} }

while(ioctl(fd,VIDIOC_ENUM_FMT, {…}

———————————————————————

程序段1查询摄像头属性

(3)设置像素格式

一般的USB摄像头都会支持YUV,可能还会支持其他更多的格式。通过上一步对摄像头所支持像素格式的查询,下面利用ioctl函数对格式进行设置,见程序段2.———————————————————————

fmt.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

fmt.fmt.pix.pixelformat = V4L2_PIX_FMT_YUYV;

fmt.fmt.pix.height = IMAGEHEIGHT;

fmt.fmt.pix.width = IMAGEWIDTH;

fmt.fmt.pix.field = V4L2_FIELD_INTERLACED;

ioctl(fd, VIDIOC_S_FMT,

———————————————————————

程序段2设置像素格式

(4)申请缓存区,并获取每个缓存的信息

V4l2捕获的数据,是存放在内核空间里的,用户不能直接访问该段内存,必须通过某些方法来转换地址。这里我们采用mmap映射方式,相关代码见程序段3.

图1车道线识别算法流程图

图2路面边缘示意图

图3干扰直线

———————————————————————

req.count=4;

req.type=V4L2_BUF_TYPE_VIDEO_CAPTURE;

req.memory=V4L2_MEMORY_MMAP;

ioctl(fd,VIDIOC_REQBUFS,

———————————————————————

程序段3映射内核空间到用户空间

(5)开始采集视频

type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

ioctl (fd, VIDIOC_STREAMON,

(6)取出缓冲区中已经采样的缓存

ioctl(fd,VIDIOC_DQBUF,

(7)停止采集和关闭设备

int close_v4l2(void)

{ ioctl(fd, VIDIOC_STREAMOFF,

…}

实验测试

本文设计的视频图像采集模块及测试演示系统实物图如图4所示。

在学校外的新兰路上采集到了回旋曲线、抛物线、直线三种结构化道路图像,对采集到的三种道路图像应用车道线识别算法处理,提取出车道标志线,效果图如5所示。从效果图中可以看出该算法基本上对由光照的强弱、对阴影区域和对道路的质量等造成的问题影响不大,表现出很好的识别效果。

图4视频图像采集演示系统

图5三种结构化道路车道线提取效果图

(一)识别效果分析此分析的实验是在MATLAB上进行的。测试评估是通过本文的识别算法的效果与人工扫描获得的图像真实值进行比较得出算法的各项指标。判断识别正确与否的原则是:

(1)当识别的结果与实际值误差在0.5m之内,并且角度变化在8°之内的目标认为是正确识别,否则认为是误识别。

(2)真实值中存在而系统没有识别出来的认为是漏检,误检和漏检都认为是错误识别。

(3)真实值中没有,但是系统识别出来的车道线算是误识别。

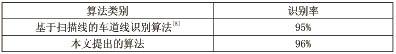

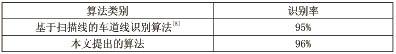

根据本文提出的车道线识别算法,分别选取了上述三种结构化道路场景的500帧图像进行测试,识别率对照表如下所示。

(二)响应速度分析

运行MATLAB软件需要耗费很多的系统资源,使得算法在其下的运行速度比较慢,所以不适合用MATLAB进行算法的响应速度测试。本文提出的算法先用C语言实现,然后在Linux环境下使用gettimeofday()函数来计算运行时间。本文算法在Ubuntu Linux平台上的处理时间平均约为27.8ms.

本文提出的车道线识别算法在识别能力和响应速度上都比以往的算法有所提高,能够满足实际应用的需要,但性能还需要进一步的优化。

结束语

基于达芬奇技术的OMAP3530实现了车道线识别检测的功能。ARM核控制OV7670摄像头捕获到道路图像,然后经由DSP/BIOS Link传输到DSP核,由DSP核完成车道线的识别检测,最后提取到清晰的车道标志线。试验结果表明,本算法可以保证车道线识别的准确性、实时性和鲁棒性,能够满足实际需要。

表1两种算法识别率对照表

引言

本文采用ARM+DSP双核架构的OMAP3530系列的处理器,道路图像处理部分由支持浮点运算的DSP核来完成,图像采集工作和系统的控制工作由ARM核来完成,这样的作业分配提高了系统的实时性、集成性和可靠性。

车道线识别算法研究

本文提出的车道线识别算法的流程如下图1所示,首先通过OV7670摄像头捕获道路图像,然后按照流程图中的步骤处理图像,最后得到清晰的车道标志线,为以后智能车辆路径规划和避障提供支持。

道路图像灰度化

图像灰度变换是对图像像素进行拉伸,从而扩大图像的灰度级范围,进一步扩展图像的对比度、增加图像的动态范围、使图像更加清晰、特征更加明显,是图像增强的有效手段。我们采集到的道路图像是彩色图像,颜色模型采用RGB模型。由于人眼对颜色的敏感度不同,等量的红、蓝、绿混合不能得到对应亮度相同的灰度值,大量的实验数据表明,当使用0.3份红色、0.59份绿色、0.11份蓝色混合后可以得到最合理的灰度图像,即如公式(1)所示:

灰度值=0.3R+0.59G+0.11B(1)

根据公式(1)就可以算出当前像素对应的灰度值,将其作为图像中彩色像素对应的灰度值。

道路图像滤波

原始图像都或多或少的存在噪声干扰,噪声影响了后续图像的分析。这就要求在分析图像之前对图像进行滤波,去除噪声和假轮廓,图像滤波的过程就是让图像的低频成分通过,阻止属于高频部分中的噪声信号,也就是平时所说的低通滤波。但是在图像平滑过程中也阻止了高频部分的图像边缘,使得图像边缘模糊化。所以应找到能消除噪声,同时尽量保持图像细节,边缘轮廓的算法,又要保证智能车辆视觉导航系统对实时性的要求。中值滤波能够在抑制高频信号中的随机噪声的同时不使边缘模糊,可以抑制随机的点状噪声,抑制持续期小于1/2窗口的脉冲信号,但不影响斜坡信号和阶跃信号,能够削弱三角信号中的顶部峰值信号,因而受到欢迎,它属于非线性滤波。

中值滤波是将邻域中的像素按灰度级排序,取其中间值为输出像素。中值计算过程中使用到的像素数和邻域的空间范围影响到中值滤波的效果。本文采用3×3方形中值滤波模板对图像进行预处理既能取得较好的滤波效果,又能节省运算时间。

图像边缘增强

在车辆视觉导航系统中,道路边缘信息可以提供路径保持和路径跟踪的位置信息,是实现车辆自主导航功能不可或缺的。边缘增强的目的在于突出道路的边缘信息,以利于道路车道线的识别,有助于克服道路光照不均的影响。我们对滤波后的图像从水平和垂直两个方向进行边缘增强,可以得到非常好的效果。

图像边缘检测

在图像的多目标检测和识别技术中,边缘检测作为一种预处理算法在机器视觉技术中占有重要地位。边缘检测的算法很多,参考各种算法的优缺点,并结合道路检测的复杂性,我们这里选用Sobel算子。

Sobel边缘算子是一种一阶差分算子。它可以有效地消除道路图像中的大部分无用信息。它可以有效的抑制图像中的噪声,它的计算量比较小,容易实现,对于实时性要求比较高的系统,该算法有很大的优势。

车道标志线提取

本文重点讨论道路区域车道线的提取。日常生活中最常见的路面边界是直线,车辆主要也是在直线路面上行驶的。平时见到的直线路面边界是成一定角度的两条直线,根据三维空间点投影到二维平面的特点,直线路面边界在二维平面上形成两条相交的直线,直线路面边缘提取算法如下:

(1)根据二维直线路面的实际情况,建立X-Y坐标系,并给出恰当的路面边缘解析方程。

(2)根据图像的特点,取一组合理的ρ、θ范围和步长,设置累加器为零。将图像的解析方程转化成极坐标下的形式,即ρ=xcosθ+ysinθ,如图2所示,ρ为原点到直线垂直距离,θ为X轴与垂线之间的夹角。

(3)对梯度图上超过门限值的每个点作Hough变换,并对相应的累加器加1.

(4)找出累加器A(ρ,θ)上的极大值ρM、θM.通过这两个值可以找出图像中极有可能的边界。

(5)去除干扰。根据三维物体在摄像机上成像的特点,三维空间中平行的路面边缘在二维平面形成两条成一定角度的相交直线,如图3中虚线所示。但由于路面噪声的影响,在累加器A(ρ,θ)上的极大值ρM、θM周围存在多个较大值,它们在X-Y轴上对应的直线如图3中两条实线所示,显然这不是要求的边缘,所以将累加器ρM、θM周围点置0.

(6)找出累加器A(ρ,θ)上次大值ρM、θM.A(ρ,θ)上的次大值对应图像中路面的另一条边界。

(7)得到相应的X-Y上对应直线方程。进一步可以得到:b=-ρ/sinθ,k=ctgθ通过这两个方程式得到ρ、θ值之后,可以求得相应的k、b值。

由于图像的连续性,图像序列中车道线的位置不会发生突变,我们在识别一帧图像的车道线时是以上一帧的识别结果为依据,动态地规划搜索区域,动态地规划Hough变化的ρ和θ值,这样就减少了计算量,提高了算法的实时性,也可提高可靠性。

系统硬件设计

本文选取ICETEK-OMAP3530-Mini开发板为实验平台,该开发板是由北京瑞泰创新科技有限责任公司与美国德州仪器公司合作推出,是一个开放的OMAP3530的硬件平台,它是以TI最新的、高性能的ARM CortexA8处理器OMAP3530为核心,以DSP64x+内核作为强劲的辅助图像处理,优化硬件2D/3D加速器,形成一个精简完备的计算机系统。

选用CMOS摄像头OV7670.OV7670是Omnivision公司生产的一款30万像素的彩色图像传感器芯片,体积小、工作电压低,提供单片VGA摄像头和影像处理器的所有功能。其特点有:灵敏度高,适合低亮度下使用;标准串行摄像头控制总线(SCCB),兼容IIC接口;自动曝光控制;自动增益控制;自动白平衡;自动消除灯光条纹;自动黑电平校准;图像格式可以是原始RGB、RGB(4:2:2)、RGB565/555/444、YUV(4:2:2)、YCbCr(4:2:2)。OV7670与ICETEK-OMAP3530-Mini板通过USB接口连接在一起。

系统软件设计

OMAP3530是一款双核微处理器,由ARM核和DSP核两部分组成,二者之间软件的编程和运行都是相互独立的,通过DSP/BIOS Link完成双核之间的通信。ARM端采用嵌入式Linux操作系统,动态创建、控制和删除DSP节点,实现数据的高效传输。DSP端采用DSP/BIOS实时操作系统,支持eXPressDSP实时软件技术,由DSP/BIOS实时内核、可重构的DSP算法和第三方软件模块组成。

由系统结构可见,软件设计主要包括:ARM端引导程序和Linux系统的移植;捕获道路图像程序。

ARM端引导程序和Linux系统的移植

为便于项目的开发和调试,ICETEK-OMAP3530-Mini板采用SD卡启动,本系统中使用的X-Loader的版本是x-loader1.4.2,U-boot的版本是Uboot-2009.01,Linux内核的版本是Linux-2.6.28,Busybox的版本是busybox-1.12.2,该过程的主要步骤如下:

(1)在开发主机Linux PC里安装交叉编译工具;

(2)交叉编译X-Loader,生成镜像文件x-load.bin.ift,然后转化为SD卡启动用程序MLO;

(3)交叉编译U-boot,生成u-boot.bin和mkimage工具;

(4)驱动配置并交叉编译内核,生成内核镜像文件uImage;

(5)利用Busybox制作文件系统;

(6)将上述生成的二进制文件复制到SD.

捕获道路图像

Linux系统对视频设备的操作提供了两套API,分别是Video 4 Linux(简称V4L)和Video 4 Linux 2(简称V4L2)。早期开发的V4L存在很多缺陷,Bill Dirks等人对其进行了重新设计,更名为V4L2,相比于V4L有很好的扩展性和灵活性,并且支持更多的硬件设备。这两套API不兼容,本文采用V4L2进行USB摄像头视频编程。

利用V4L2提供的接口,我们可以编写出具有视频采集功能的测试代码。下面就主要的环节做一些说明。

(1)打开视频设备

cameraFd=open(“/dev/video0”, O_RDWR, O);

(2)查询设备属性

通过调用ioctl函数和接口命令VIDIOC_QUERYCAP,查询摄像头的信息,见程序段1.

———————————————————————

if (ioctl(fd, VIDIOC_QUERYCAP, == -1) {

…

} else {…

if ((cap.capabilities V4L2_CAP_VIDEO_CAPTURE) == V4L2_CAP_VIDEO_ CAPTURE) {

…}

if ((cap.capabilities V4L2_CAP_STREAMING) == V4L2_CAP_STREAMING) {

…} }

while(ioctl(fd,VIDIOC_ENUM_FMT, {…}

———————————————————————

程序段1查询摄像头属性

(3)设置像素格式

一般的USB摄像头都会支持YUV,可能还会支持其他更多的格式。通过上一步对摄像头所支持像素格式的查询,下面利用ioctl函数对格式进行设置,见程序段2.———————————————————————

fmt.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

fmt.fmt.pix.pixelformat = V4L2_PIX_FMT_YUYV;

fmt.fmt.pix.height = IMAGEHEIGHT;

fmt.fmt.pix.width = IMAGEWIDTH;

fmt.fmt.pix.field = V4L2_FIELD_INTERLACED;

ioctl(fd, VIDIOC_S_FMT,

———————————————————————

程序段2设置像素格式

(4)申请缓存区,并获取每个缓存的信息

V4l2捕获的数据,是存放在内核空间里的,用户不能直接访问该段内存,必须通过某些方法来转换地址。这里我们采用mmap映射方式,相关代码见程序段3.

图1车道线识别算法流程图

图2路面边缘示意图

图3干扰直线

———————————————————————

req.count=4;

req.type=V4L2_BUF_TYPE_VIDEO_CAPTURE;

req.memory=V4L2_MEMORY_MMAP;

ioctl(fd,VIDIOC_REQBUFS,

———————————————————————

程序段3映射内核空间到用户空间

(5)开始采集视频

type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

ioctl (fd, VIDIOC_STREAMON,

(6)取出缓冲区中已经采样的缓存

ioctl(fd,VIDIOC_DQBUF,

(7)停止采集和关闭设备

int close_v4l2(void)

{ ioctl(fd, VIDIOC_STREAMOFF,

…}

实验测试

本文设计的视频图像采集模块及测试演示系统实物图如图4所示。

在学校外的新兰路上采集到了回旋曲线、抛物线、直线三种结构化道路图像,对采集到的三种道路图像应用车道线识别算法处理,提取出车道标志线,效果图如5所示。从效果图中可以看出该算法基本上对由光照的强弱、对阴影区域和对道路的质量等造成的问题影响不大,表现出很好的识别效果。

图4视频图像采集演示系统

图5三种结构化道路车道线提取效果图

(一)识别效果分析此分析的实验是在MATLAB上进行的。测试评估是通过本文的识别算法的效果与人工扫描获得的图像真实值进行比较得出算法的各项指标。判断识别正确与否的原则是:

(1)当识别的结果与实际值误差在0.5m之内,并且角度变化在8°之内的目标认为是正确识别,否则认为是误识别。

(2)真实值中存在而系统没有识别出来的认为是漏检,误检和漏检都认为是错误识别。

(3)真实值中没有,但是系统识别出来的车道线算是误识别。

根据本文提出的车道线识别算法,分别选取了上述三种结构化道路场景的500帧图像进行测试,识别率对照表如下所示。

(二)响应速度分析

运行MATLAB软件需要耗费很多的系统资源,使得算法在其下的运行速度比较慢,所以不适合用MATLAB进行算法的响应速度测试。本文提出的算法先用C语言实现,然后在Linux环境下使用gettimeofday()函数来计算运行时间。本文算法在Ubuntu Linux平台上的处理时间平均约为27.8ms.

本文提出的车道线识别算法在识别能力和响应速度上都比以往的算法有所提高,能够满足实际应用的需要,但性能还需要进一步的优化。

结束语

基于达芬奇技术的OMAP3530实现了车道线识别检测的功能。ARM核控制OV7670摄像头捕获到道路图像,然后经由DSP/BIOS Link传输到DSP核,由DSP核完成车道线的识别检测,最后提取到清晰的车道标志线。试验结果表明,本算法可以保证车道线识别的准确性、实时性和鲁棒性,能够满足实际需要。

表1两种算法识别率对照表

举报

举报

举报

举报