验证

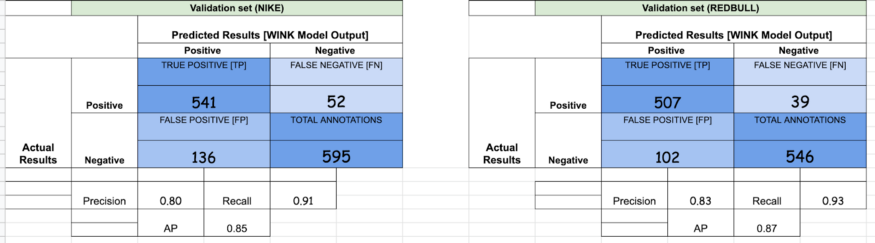

为了计算不同的集成方法,我们将跟踪以下参数:

True positive:预测框与gt匹配

False Positives:预测框是错误的

False Negatives:没有预测,但是存在gt。

Precision:度量你的预测有多准确。也就是说,你的预测正确的百分比[TP/ (TP + FP)]

Recall:度量gt被预测的百分比[TP/ (TP + FN)]

Average Precision:precision-recall图的曲线下面积

使用的模型

为了理解集成是如何起作用的,我们提供了用于实验的独立模型的结果。

1. YoloV3:

2. Faster R-CNN — ResNeXt 101 [X101-FPN]:

集成实验

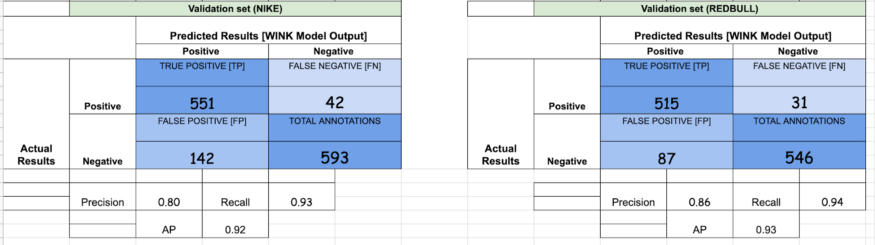

1. OR — [YoloV3, X101-FPN]

如果你仔细观察,FPs的数量增加了,这反过来降低了精度。与此同时,TPs数量的增加反过来又增加了召回。这是使用OR方法时可以观察到的一般趋势。

2. AND — [YoloV3, X101-FPN]

与我们使用OR方法观察到的情况相反,在AND方法中,我们最终获得了较高的精度和较低的召回率,因为几乎所有的假阳性都被删除了,因为YoloV3和X101的大多数FPs是不同的。

验证

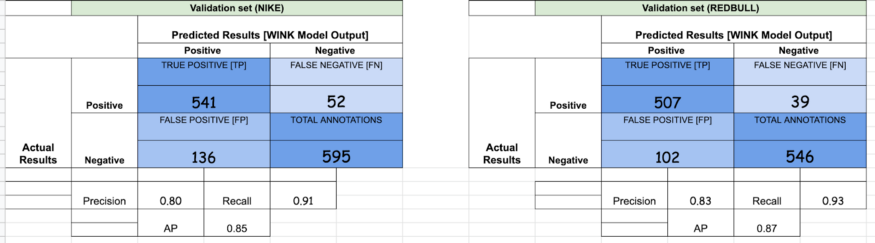

为了计算不同的集成方法,我们将跟踪以下参数:

True positive:预测框与gt匹配

False Positives:预测框是错误的

False Negatives:没有预测,但是存在gt。

Precision:度量你的预测有多准确。也就是说,你的预测正确的百分比[TP/ (TP + FP)]

Recall:度量gt被预测的百分比[TP/ (TP + FN)]

Average Precision:precision-recall图的曲线下面积

使用的模型

为了理解集成是如何起作用的,我们提供了用于实验的独立模型的结果。

1. YoloV3:

2. Faster R-CNN — ResNeXt 101 [X101-FPN]:

集成实验

1. OR — [YoloV3, X101-FPN]

如果你仔细观察,FPs的数量增加了,这反过来降低了精度。与此同时,TPs数量的增加反过来又增加了召回。这是使用OR方法时可以观察到的一般趋势。

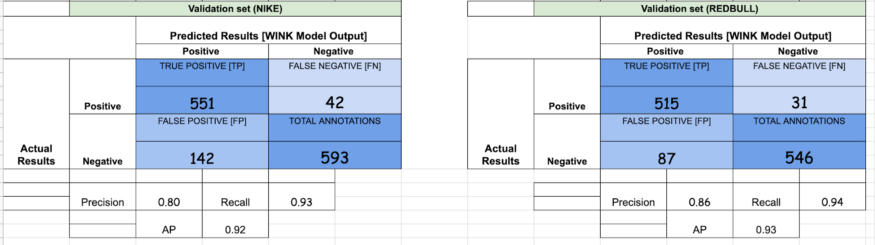

2. AND — [YoloV3, X101-FPN]

与我们使用OR方法观察到的情况相反,在AND方法中,我们最终获得了较高的精度和较低的召回率,因为几乎所有的假阳性都被删除了,因为YoloV3和X101的大多数FPs是不同的。

举报

举报

举报

举报

举报

举报

举报

举报

举报

举报